Digitale bildgebende Verfahren/ Druckversion

Vorwort

BearbeitenEinführung

BearbeitenDieses Buch möchte dem Leser einen ersten Überblick über die vielfältigen Möglichkeiten geben, wie digitale Bilder erzeugt werden können, welche Eigenschaften diese gespeichert haben und wie sie für einen Betrachter wiedergegeben werden können. Die Bedeutung von bildgebenden Verfahren ist ungebrochen. 2015 wurde von der Generalversammlung der Vereinten Nationen als Internationales Jahr des Lichts und der lichtbasierten Technologien ausgerufen. Dies soll auch an die zentrale wissenschaftliche Bedeutung des Lichts erinnern, da durch Licht unser Kosmos besser verstanden, kranke Menschen besser behandelt und neue Kommunikationsmittel erfunden werden können.

Lichtteilchen haben keine Ruhemasse und bewegen sich daher immer mit Lichtgeschwindigkeit. Daraus erwächst das Prinzip vom Welle-Teilchen-Dualismus, da Licht sowohl als elektromagnetische Welle (Lichtwelle) als auch als Korpuskel (Photonen) interpretiert werden kann oder sogar muss. Insofern spielen sowohl Strahlungsaspekte eine Rolle, wie zum Beispiel bei Lichtstrahlen in der geometrischen Optik oder bei klassisch erklärbaren Wellenphänomenen, wie Brechung und quantenmechanische Wellenphänomene, allen voran die Beugung.

Die Photographie wurde in der ersten Hälfte des 19. Jahrhunderts entwickelt und stellte eine revolutionäre Technik dar, weil optische Abbildungen damit dauerhaft gespeichert werden konnten. Der aus den altgriechischen Wörtern "φωτός" ("photós": zu Deutsch "des Lichtes") und γράφειν ("gráphein": zu Deutsch "schreiben" oder "zeichnen") zusammengesetzte Begriff geht auf den Astronomen Johann Heinrich Mädler (1794–1874) zurück, der ihn als Alternative zu "Lichtzeichnenkunst" erstmals in seinem Beitrag mit dem Titel "Photographie" in der Beilage der überregional erschienene Tageszeitung "Königlich privilegierten Berlinischen Zeitung von Staats- und gelehrten Sachen" vom 25. Februar 1839 erwähnte. Mädler beschrieb dort die beiden damals erfundenen photochemischen Verfahren mit Silbersalzen:[1]

- Die direkt im Auflicht als Unikat registrierte photopositive Daguerreotypie von Louis Daguerre (1787–1851). Das Bild auf einer mit Silber beschichteten und mit Jod bedampften, spiegelglatt polierten Metallplatte ist stets spiegelverkehrt zum aufgenommenen Objekt.

- Das photonegative Verfahren (fotogenische Zeichnung) von William Henry Fox Talbot (1800–1877). Hier kann das gewonnene Negativbild anschließend beliebig oft mit Hilfe von Sonnenlicht durch Schattenwurf im Durchlicht auf lichtempfindliches Papier übertragen (Kontaktkopie) danach photochemisch fixiert werden (Schutzverfahren).

In heutiger Zeit ist es zunehmend üblich, dass Information, die in Form von Licht vorliegt, nicht mehr mit photochemischen Filmmaterial, sondern mit elektronischen Sensoren registriert wird. Dadurch wird die Digitalisierung der Daten und deren informationstechnische Weiterverarbeitung vereinfacht. Gleichermaßen gilt dies für die computergestützte Generierung, die Speicherung, die Nachbearbeitung und die Wiedergabe digitaler Steh- und Bewegtbilder. Digitale Bilder können Information in Form von verschiedenen Helligkeiten, in Form verschiedener Farben oder in einer Kombination von beidem beinhalten, und sie können zwei- oder dreidimensional gestaltet sein.

Darüber hinaus ist es möglich, dieses Prinzip auf die elektromagnetischen Wellenlängenbereiche zu übertragen, die für Menschen unsichtbar sind. So können beispielsweise Mikrowellen oder Infrarotstrahlung zur Bildgebung herangezogen werden, aber genauso ist es möglich, hochenergetische Photonen im Ultraviolett-, im Röntgen- oder sogar im Gammastrahlenbereich dafür zu verwenden. Dies beschränkt sich keineswegs auf medizinische Verfahren, für die sich der Begriff bildgebende Verfahren in besonderem Maße etabliert hat.

Der Vollständigkeit halber sei noch erwähnt, dass auch mit Materiewellen, also zum Beispiel mit Elektronen- oder Ionenstrahlen, teilchenoptische Abbildungen gemacht werden können, die heute in der Regel ebenfalls digital registriert werden. Teilchen mit Ruhemasse können sich zwar nicht mit Lichtgeschwindigkeit bewegen, ihnen kann aber dennoch die De-Broglie-Wellenlänge zugeordnet werden.

Eine weitere Klasse von bildgebenden Apparaturen rastern Oberflächen oder Körper, wie zum Beispiel bei der Rastersondenmikroskopie und -spektroskopie (Rasterelektronen-, Rastertunnel-, Rasterkraft- oder Rasternahfeldmikroskope) oder beim Einsatz von Scannern. Hierbei werden die Bilder nicht unmittelbar gewonnen, sondern aus zeitlich und örtlich versetzt gewonnenen Signalen synthetisiert.

Erwartungen an den Leser

BearbeitenDem Leser wird es nützlich sein, wenn ihm die folgenden Begriffe und Zusammenhänge aus der Optik geläufig sind.

Es gibt mehrere, ganz verschiedenartige Möglichkeiten, elektromagnetische Wellen und somit auch Lichtteilchen zu beeinflussen:

- Emission (spontane (also zufällige) oder stimulierte (also angeregte oder erzwungene) Erzeugung)

- Remission durch Reflexion (Spiegelung, Reflexionsgesetz: Einfallswinkel gleich Ausfallswinkel) oder Transmission (Hindurchschickung)

- Absorption (Vernichtung von Photonen durch Dissipation oder Extinktion)

- Refraktion (Brechung, Snelliussches Brechungsgesetz) inklusive Dispersion (Verteilung verschiedener Wellenlängen)

- Diffraktion (Beugung an Kanten)

- Diffusion (Streuung an Elementarteilchen, Atomen, Molekülen oder Feinstaub mit und ohne Änderung der Energie)

- Polarisation (lineare, zirkulare oder elliptische Auslenkung)

- Gravitation (Massenanziehung)

Der letzte Punkt stellt einen Sonderfall dar, da die Photonen bei nicht-euklidischer Geometrie des Raumes durch Massen gar nicht unmittelbar beeinflusst werden, sondern sich ebenfalls geradlinig ausbreiten. Trotz der Tatsache, dass es im Universum Gravitationslinseneffekte gibt, ist dieser Effekt für diese Veröffentlichung nicht relevant.

Alle anderen der genannten Effekte werden uns hier jedoch immer wieder begegnen, so dass es sehr hilfreich ist, die Eigenschaften und Ausprägungen dieser grundlegenden Prinzipien verstanden zu haben. Darüberhinaus werden einfache Gleichungen, wie die trigonometrischen Funktionen, die Abbildungsgleichung (respektive Linsenformel) oder der Strahlensatz als bekannt vorausgesetzt.

Das Verhalten der elektromagnetischen Strahlung kann oft rein geometrisch behandelt werden. In manchen Fällen ist es daher nützlich, die elektromagnetische Strahlung als Teilchen zu betrachten, die sich geradlinig durch Raumabschnitte bewegen. In anderen Fällen ist es unerlässlich, auch die wellenförmige Ausbreitung des Lichts in geometrische Schattenräume zu berücksichtigen. Die bewusste Wahl der jeweils besser geeigneten Betrachtungsweise kann die Überlegungen und Schlussfolgerungen oft deutlich vereinfachen, in vielen Fällen ist es jedoch notwendig, beide Ausprägungen der elektromagnetischen Strahlung zu berücksichtigen, um vollständige und korrekte Aussagen machen zu können. Weitere als bekannt vorausgesetzte Begriffe aus der Wellentheorie sind daher:

- Elementarwellen / Huygenssches Prinzip

- Kohärenz / Interferenz

Mit diesem Rüstzeug gewappnet, sollte es jedem Leser möglich sein, den Inhalten der verschiedenen Kapitel zu folgen und gegebenenfalls Anhaltspunkte für weitergehende Recherchen zu finden.

Einzelnachweise

Bearbeiten- ↑ Johann Heinrich Mädler: Königlich privilegierte Berlinischen Zeitung von Staats- und gelehrten Sachen, Nummer 47, Beilage. Im Verlage der Vossischen Erben (Redakteur E. F. Lessing), Vossische Zeitungs-Expedition in der breiten Straße No. 8. Montag, den 25sten Februar 1839.

Grundlagen

BearbeitenDieses Kapitel beschäftigt sich mit prinzipiellen Eigenschaften von optischen Abbildungen. In den folgenden Abschnitten sind einige grundlegende Aspekte aufgeführt, die bei der Aufnahme und Registrierung von Bildern eine Rolle spielen.

Optik

BearbeitenDie Optik (von altgriechisch ὀπτική τέχνη (optikḗ téchnē), zu Deutsch: „Lehre vom Sehen“) beschäftigt sich mit der Ausbreitung von Licht unter Berücksichtigung der Wechselwirkung zwischen Licht und Materie. Im engeren Sinne werden in der Optik optische Systeme behandelt, mit denen Objekte abgebildet werden können. Reelle Bilder können beispielsweise mit Bildwänden, photographischen Filmen oder elektronischen Bildsensoren aufgefangen werden, wohingegen virtuelle Bilder direkt durch das menschliche Auge gesehen werden können.

Lichtquellen haben immer eine endliche Ausdehnung. Wenn die leuchtende Fläche im Vergleich zu einem ausgedehnten optischen System klein ist, wird die entsprechende Lichtquelle als punktförmig bezeichnet. In der Praxis kann ein Fixstern als eine solche punktförmige Lichtquelle betrachtet werden. Im Labor kann eine punktförmige Lichtquelle durch die Beleuchtung einer kleinen Kreislochblende aus einer hinreichend großen Entfernung erzeugt werden. Das aus der Blende austretende Licht bildet ein Lichtbündel. Ein Lichtstrahl kann durch ein paralleles Lichtbündel mit kleinem Durchmesser angenähert werden. Lichtstrahlen werden in der geometrischen Optik verwendet, um die Richtung des Flusses der Lichtenergie anzugeben.

Beugungseffekte sind durch die Welleneigenschaften des Lichtes bedingt und treten immer auf, wenn es auf Kanten trifft. Die Beugung wird in der Wellenoptik behandelt und wird in der geometrischen Optik nicht berücksichtigt.

Die Lichtgeschwindigkeit im Vakuum ist eine festgelegte Größe, die für alle Arten elektromagnetischer Strahlung gilt:

Die Wellenlänge der mit der Frequenz transversal schwingenden, elektromagnetischen Welle beträgt hierbei:

Die Vektoren der elektrischen und der magnetischen Feldstärke stehen bei elektromagnetischen Wellen stets senkrecht zueinander und außerdem beide senkrecht zur Ausbreitungsrichtung.

Brechung

Bearbeiten

In allen anderen optischen Medien bleibt die Schwingungsfrequenz elektromagnetischer Wellen im Vergleich zu derjenigen im Vakuum erhalten, aber die Lichtgeschwindigkeit und die Wellenlänge sind kleiner. Dies kann durch den maßeinheitenlosen Brechungsindex (auch Brechzahl genannt) des optischen Mediums beschrieben werden:

Der Brechungsindex des Vakuums ist demzufolge gleich Eins, und bei allen anderen optischen Medien ist der Brechungsindex größer als Eins. Bei Gasen ist der Brechungsindex bei normalem Luftdruck nur geringfügig größer als Eins. Die meisten optischen Medien aus flüssigem oder festem Material haben typische Brechungsindices zwischen 1,3 und 2,0. Wasser hat bei Zimmertemperatur einen Brechungsindex von 1,333. Besondere Materialien haben Brechungsindices, die größer als Zwei sind, wie zum Beispiel Dimant (Kohlenstoffkristall) mit rund 2,4 oder Rutil (Titandioxid) mit rund 3,1.

Beim Übergang von Lichtstrahlen von einem optischen Medium mit der Brechzahl in ein optisches Medium mit der Brechzahl wird ein einfallender Lichtstrahl (in der Abbildung rechts weiß) zu einem Teil in das Einfallsmedium zurück gespiegelt (Reflexion, in der Abbildung rechts dunkelgrau) und zu einem anderen Teil in das Ausfallsmedium gebrochen (Refraktion, in der Abbildung rechts hellgrau). Die Richtungen der Reflexion und der Refraktion werden über die Winkel zur Flächennormalen (Lot) an der Stelle des Übergangs der beiden optischen Medien bestimmt.

Für die Reflexion gilt das Reflexionsgesetz:

- Einfallswinkel gleich Ausfallswinkel .

Für die Refraktion gilt das Snelliussche Brechungsgesetz:

Ist größer als , wird der Lichtstrahl zum Lot hingebrochen, und ist größer als , wird der Lichtstrahl vom Lot weggebrochen.

Am Einheitskreis (Radius gleich Eins) gilt:

und:

Das Snelliussche Brechungsgesetz geht damit in die folgende Form über:

Es gilt entsprechend:

Zur Herleitung des Brechungsgesetzes unter Berücksichtigung der Ausbreitung mit Huygensschen Elementarwellen mit der jeweiligen Lichtgeschwindigkeit auf dem schnellsten Weg entsprechend dem Fermatschen Prinzip siehe auch:

→ Kapitel "Bildaufnahme" / Abschnitt "Ablenkung von Lichtstrahlen"

Optische Achse

Bearbeiten

Die optische Achse beschreibt in der geometrischen Optik die Rotationsachse aller rotationssymmetrischen Bestandteile einer optischen Abbildung oder eines optischen Systems.

Schnittebene von zweidimensionalen Skizzen werden üblicherweise durch die optische Achse gelegt, so dass die Schnitte der rotationssymmetrischen optischen Elemente an dieser Achse gespiegelt dargestellt werden. Die optische Achse wird in solchen Skizzen immer als Strichpunktlinie dargestellt.

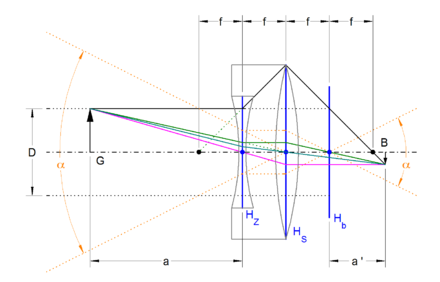

Hauptebenen

Bearbeiten

Hauptebenen stehen in der Regel senkrecht zur optischen Achse. Sie beschreiben vereinfacht betrachtet Flächen, an denen alle Strahlen in einem optischen Strahlengang gebrochen oder gespiegelt werden, und sie teilen den Objektraum links der Hauptebene vom Bildraum rechts der Hauptebene. In der Praxis gilt dies mit hinreichender Genauigkeit häufig nur für achsnahe Strahlen (paraxialer Strahlengang mit Gaußschen Strahlen).

Bei konvergenten Systemen werden die Strahlen zur optischen Achse abgelenkt, und bei divergenten Systemen werden die Strahlen von der optischen Achse weggelenkt.

Von den Hauptebenen werden in Richtung der optischen Achse Schnittweiten, Brennweiten, Objektweiten und Bildweiten gemessen. Die Schnittpunkte der Hauptebenen mit der optischen Achse werden als Hauptpunkte bezeichnet. Lichtstrahlen, die durch einen Hauptpunkt gehen, heißen Hauptstrahlen und werden nicht abgelenkt.

Linsen haben zwei Hauptebenen, deren Hauptpunkte mit den Scheitelpunkten der Linsenoberflächen auf der optischen Achse übereinstimmen können. Meist liegen sie jedoch zwischen der Mitte und den Scheitelpunkten der Linse. Bei hinreichend dünnen Linsen fallen die beiden Hauptebenen annähernd zu einer einzigen Hauptebene in der Mitte der Linse zusammen, so dass sich Berechnungen und graphische Darstellungen mit nur einer Hauptebene deutlich vereinfachen lassen. Von dünnen Linsen wird gesprochen, wenn der Radius der Oberflächen und somit auch die Brennweite deutlich größer sind als die Dicke der Linse entlang der optischen Achse.

Optische Systeme, wie zum Beispiel ein Objektiv, können sehr viele Hauptebenen haben, die nicht notwendigerweise alle im optischen System liegen müssen, wie zum Beispiel bei Retrofokusobjektiven oder teleskopischen Objektiven.

Messtechnisch können von außen unmittelbar nur die Lagen der beiden äußersten Hauptebenen eines optischen Systems bestimmt werden. Bei Zoomobjektiven, also bei Objektiven mit variabler Brennweite, variiert die Lage der Hauptebenen mit der Einstellung der Brennweite. Auch bei Objektiven mit innenliegender Fokussierung verändert sich beim Scharfstellen die Lage der Hauptebenen zueinander.

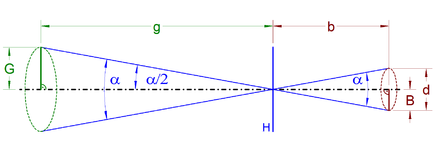

Bildwinkel

Bearbeiten

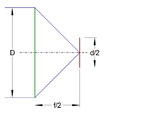

Der Bildwinkel ist der ebene Winkel, innerhalb dessen das reelle Bild des Objektes in der Bildebene vom bildseitigen Hauptpunkt eines optischen Systems aus gesehen werden kann. Er wird durch die äußeren zur Abbildung beitragenden Hauptstrahlen gebildet, die durch den Hauptpunkt gehen.

Mathematisch ist der Bildwinkel wie folgt definiert, wenn die Bildgröße (sie wird manchmal auch als Bildhöhe bezeichnet) beziehungsweise der Radius des Bildkreises von der optischen Achse aus gemessen ist und die Bildweite zwischen Hauptebene und Bildebene darstellt:

- ,

wobei der Radius des Bildkreises gleich dem halben Bildkreisdurchmesser ist:

Die Bildweite ergibt sich daraus folgendermaßen:

Der Objektwinkel ist der ebene Winkel, innerhalb dessen ein abgebildetes Objekt in der Objektebene (respektive in der Schärfeebene) vom objektseitigen Hauptpunkt eines optischen Systems aus gesehen werden kann, und er ist mit dem Bildwinkel identisch. Daher können unter Berücksichtigung des Abbildungsmaßstabs auch die Objektgröße (sie wird auch als Gegenstandshöhe oder Gegenstandsgröße bezeichnet) beziehungsweise der Radius des Objektkreises von der optischen Achse aus gemessen und die Objektweite (sie wird auch als Gegenstandsweite bezeichnet) zwischen Hauptebene und Objektebene zur Berechnung des Bildwinkels herangezogen werden:

Wegen der ähnlichen rechtwinkligen Dreiecke gilt, dass die Verhältnisse der Katheten gleich sind:

Daraus folgt:

Brennweite

Bearbeiten

Die Brennweite ist bei einer optischen Abbildung mit lichtsammelnden Elementen definiert als die von der letzten Hauptebene gemessene Schnittweite paraxialer Lichtstrahlen bei unendlicher Objektweite . In diesem Fall schneiden sich die Strahlen im bildseitigen Brennpunkt und die Bildweite ist identisch mit der Brennweite :

Die Brennweite kann also als Bildweite gemessen werden, wenn die Objektweite unendlich ist.

Der Kehrwert der Brennweite wird Brechkraft genannt:

Liegt das Objekt außerhalb der optischen Achse, wird es nicht in den Brennpunkt abgebildet, sondern in die Brennebene, die durch den Brennpunkt geht und senkrecht auf der optischen Achse steht. Für ein Objekt mit unendlicher Objektweite, das zur optischen Achse unter dem Winkel erscheint, ergibt sich bei gegebener bildseitiger Brennweite die von der optischen Achse gemessene Bildhöhe wie folgt:

Oder nach Umstellung aufgelöst nach dem Winkel in Abhängigkeit der beiden Längen:

Wenn die Bilddiagonale eines Rechteckes beziehungsweise der Bildkreisdurchmesser bekannt sind, ergibt sich die Brennweite als Funktion des (diagonalen) Bildwinkels zu:

Beziehungsweise umgekehrt, der Bildwinkel als Funktion der Brennweite :

Ein Objekt, das in der Brennebene liegt, wird ins Unendliche abgebildet, und der objektseitige Brennpunkt wird bildseitig daher auf der optischen Achse ins Unendliche abgebildet.

Wegen der Dispersion kann die Brennweite bei der Verwendung von brechenden Materialien von der Wellenlänge der abbildenden Strahlen abhängen. Die Dispersion eines bestimmten optischen Mediums kann durch dessen Abbe-Zahl beschrieben werden:

→ siehe hierzu auch Kapitel "Bildaufnahme" / Abschnitt "Chromatische Aberration"

Normalbrennweite

BearbeitenDie Brennweite ist bei einer optischen Abbildung nicht ausreichend, um die Größe einer Aufnahme zu kennzeichnen. In einigen Fällen ist die Bildgröße standardisiert, wie zum Beispiel beim rechteckigen Format des Kleinbildfilms, so dass aus der Angabe einer beliebigen Brennweite auch auf den maximal möglichen Bildwinkel der Bilddiagonale beziehungsweise des Bildkreisdurchmessers geschlossen werden kann.

Es kann eine empirisch zu bestimmende Normalbrennweite definiert werden, bei der ein Bild mit dem Bildwinkel aufgenommen wird, mit dem das abgebildete Objekt mit bloßem Auge bei hinreichender Auflösung gesehen werden kann. Dies ist der Fall, wenn der Bildwinkel des Auges wegen der physiologischen Schwankungsbreite ungefähr zwischen 40° und 55° liegt.

Brennweiten, die kürzer als die Normalbrennweite sind, erzeugen weitwinklige Aufnahmen mit größeren Bildwinkeln, und Brennweiten, die länger als die Normalbrennweite sind, erzeugen teleskopische Aufnahmen mit kleineren Bildwinkeln. Die Größenverhältnisse der in unterschiedlichen Entfernungen aufgenommenen Gegenstände innerhalb einer Aufnahme ändern sich deutlich mit der Brennweite.

Beim durch den 35-Millimeter-Film (Kleinbildfilm) im 20. Jahrhundert sehr weit verbreiteten Kleinbildformat mit einer Bildbreite von 36 Millimetern und einer Bildhöhe von 24 Millimetern hat sich eine Normalbrennweite von

etabliert. Bei diesem Format ergibt sich rechnerisch eine Bilddiagonale beziehungsweise ein Bildkreisdurchmesser von:

Da alle Hersteller von Kleinbildkameras dieselbe, fest vorgegebene Bildgröße verwenden, ist dem Photographen bei diesem Bildformat bekannt, dass ein Objektiv mit Normalbrennweite eine Brennweite von 50 Millimetern hat. Bei anderen Bildformaten und -größen, wie sie zum Beispiel in der digitalen Photographie verwendet werden, ergeben sich zwangsläufig andere Normalbrennweiten, so dass aus der Angabe der Brennweite allein noch nicht folgt, welche Bildgröße oder welcher Bildwinkel bei der optischen Abbildung berücksichtigt wurde.

Abgesehen von einigen digitalen Systemkameras mit Bildsensoren im Kleinbildformat gibt es viele verschiedene Bildsensorgrößen und damit Normalbrennweiten (siehe auch Abschnitt Bildsensoren). Zur Bestimmung von Normalbrennweiten kann das Verhältnis zwischen Normalbrennweite und Bildkreisdurchmesser verwendet werden, das sich beim Kleinbildfilm ergibt:

Anhand der effektiven Bilddiagonalen kann somit die Normalbrennweite berechnet werden:

Beim Sonderfall unendlicher Objektweite sind Bildweite und Brennweite identisch, und der Bildwinkel bei der Normalbrennweite kann leicht aus der Brennweite und dem Radius des Bildkreises berechnet werden:

Am Beispiel des Kleinbildformates ergibt sich der Bildwinkel bei der Normalbrennweite also wie folgt:

Dieser Bildwinkel kann auch bei alle anderen Bildformaten eingesetzt werden.

Die Normalbrennweite kann mithilfe des Bildwinkels bei der Normalbrennweite bei unendlicher Objektweite auch aus der Brennweite und dem dazugehörigen Bildwinkel bestimmt werden:

Ferner lässt sich auch die Bilddiagonale berechnen, wenn die Brennweite bekannt ist und der Bildwinkel gemessen werden kann:

Für einige gängige Bildsensorformate resultieren die folgenden Bilddiagonalen und Normalbrennweiten, sowie die entsprechenden Schärfentiefebereiche (siehe auch Abschnitt Schärfentiefe) für menschliche Betrachter beispielsweise bei einer Blendenzahl von 2,0 (siehe auch Abschnitt Blendenzahl) und einer Objektweite von einem Meter. Ferner die Bildpunktgröße bei 16 Millionen quadratischen Bildpunkten (siehe auch Abschnitt Punktabstand), der dazugehörige tolerierbare Fokussierungsfehler in der Bildebene bei der Blendenzahl 2,0 (siehe auch Abschnitt Fokussierungsfehler) und der Durchmesser des entsprechenden Beugungsscheibchens für grünes Licht mit der Wellenlänge 550 Nanometer (siehe auch Abschnitt Beugungsbegrenzung):

| Bildsensorgröße Bezeichnung |

Bilddiagonale in Millimetern |

Normalbrennweite in Millimetern |

Schärfentiefe in mm bei Blendenzahl 2,0 und Objektweite 1 m |

Bildpunktgröße auf dem Bildsensor in µm bei 16 Millionen Bildpunkten |

Maximal zulässiger Fokussierungsfehler auf dem Bildsensor in µm bei Blendenzahl 2,0 |

Maximale Blendenzahl ohne Beugungsbegrenzung auf dem Bildsensor |

|---|---|---|---|---|---|---|

| 1/3,2″ | 5,6 | 6,5 | 360 | 0,99 | 2,0 | 0,74 |

| 1/2,7″ | 6,0 | 7,0 | 330 | 1,06 | 2,1 | 0,79 |

| 1/2,5″ | 6,4 | 7,5 | 310 | 1,13 | 2,3 | 0,84 |

| 1/2,3″ | 7,7 | 8,9 | 260 | 1,4 | 2,7 | 1,0 |

| 1/1,8″ | 8,9 | 10 | 240 | 1,57 | 3,1 | 1,2 |

| 2/3″ | 11,0 | 13 | 170 | 1,94 | 3,9 | 1,4 |

| 1" | 15,9 | 18 | 130 | 2,8 | 5,6 | 2,0 |

| 4/3″ | 21,6 | 25 | 90 | 3,8 | 7,6 | 2,8 |

| APS-C | 26,8 bis 28,4 | 31 bis 33 | 70 | 5 | 10 | 3,5 |

| Kleinbildformat | 43,3 | 50 | 44 | 8 | 15 | 5,6 |

| Mittelformat | 50 bis 70 | 60 bis 80 | 30 | 11 | 20 | 8,0 |

Wesentliche Unterschiede von Bildsensoren ergeben sich indirekt durch eine unterschiedliche Schärfentiefe bei gleichem Bildwinkel und gleicher Blendenzahl. Dabei gilt näherungsweise bei gleicher Anzahl der Bildpunkte (siehe auch Abschnitt Bildauflösung):

Es ergibt sich bei der Verdopplung der Bilddiagonale also in etwa eine Halbierung der Schärfetiefe. Bei großen Bildsensorformaten ist die Schärfentiefe bei offener Blende möglicherweise so stark eingeschränkt, dass abgeblendet werden muss. Ferner kann es bei der Verwendung von zusätzlichen Einstellhilfen für die Bildschärfe wie zum Beispiel Einstellscheiben oder Autofokussystemen bei kleinen Bildsensoren leicht zu Fokussierungsfehlern kommen, so dass das Bild auf dem Sensor nicht hinreichend scharf aufgenommen werden kann.

Abbildungsmaßstab

Bearbeiten

Bei photographischen Aufnahmen mit gegebener Brennweite gilt die Abbildungsgleichung (umgangssprachlich auch "Linsenformel"), die den Zusammenhang zwischen Objektweite und Bildweite herstellt:

oder anders ausgedrückt:

Aus diesen Längen lässt sich der Abbildungsmaßstab berechnen. Dieser kann bei sowohl aus dem Verhältnis von Bildweite zu Objektweite (auch Gegenstandsweite genannt), als auch aus dem Verhältnis von Bildgröße zu Objektgröße (auch Gegenstandsgröße genannt) berechnet werden:

beziehungsweise:

Umgeformt nach der Bildweite lautet der Formelzusammenhang:

Und umgeformt nach der Objektweite lautet der Formelzusammenhang:

Desgleichen können die Objektröße und die Bildgröße ausgerechnet werden:

Bei der gleichzeitigen Aufnahme von Objekten mit verschiedener Objektweite (innerhalb des hinreichend scharf abgebildeten Schärfentiefebereiches) ergeben sich also zwangsläufig unterschiedliche Abbildungsmaßstäbe. Dieser Effekt kann bei Aufnahmen, bei denen es auf Maßhaltigkeit ankommt (zum Beispiel bei einer Industrieanlagenüberwachung, in der Photogrammetrie oder bei der Portraitphotographie), dadurch reduziert werden, dass eine größere Brennweite und entsprechend größere Objektweiten gewählt werden. Alternativ ist der Einsatz von beidseitig telezentrischen Objektiven möglich, bei denen der Abbildungsmaßstab weder von der Objektweite noch von der Bildweite abhängt (siehe auch Abschnitt Telezentrie).

Für zwei Gegenstände mit einem Abstand von zehn Einheiten ergeben sich bei drei verschiedenen Brennweiten beispielsweise die folgenden Abbildungsmaßstäbe:

| Brennweite |

Objektweite |

Abbildungsmaßstab |

Abweichung der Abbildungsmaßstäbe |

|---|---|---|---|

| 10 | 100 | 0,1111 | 11,1% |

| 110 | 0,1000 | ||

| 100 | 1090 | 0,1010 | 1,0% |

| 1100 | 0,1000 | ||

| 1000 | 10990 | 0,1001 | 0,1% |

| 11000 | 0,1000 |

Relativer Abbildungsmaßstab

BearbeitenUm ein von der Brennweite und der Bildgröße unabhängiges Maß zu gewinnen, kann das Verhältnis des tatsächlichen Abbildungsmaßstabes zum entsprechenden Abbildungsmaßstab bei der Normalbrennweite gebildet werden, der sogenannte relative Abbildungsmaßstab :

Bei der Normalbrennweite ist der relative Abbildungsmaßstab eins, bei weitwinkligen Aufnahmen ist er kleiner als eins und bei teleskopischen Aufnahmen ist er größer als eins.

Zoomfaktor

Bearbeiten

Der Zoomfaktor von Objektiven, die in der Brennweite variabel sind, wird traditionell als Verhältnis der Extrembrennweiten angegeben:

Dieser Wert ist bei unendlicher Objektweite identisch mit dem Verhältnis der entsprechenden Abbildungsmaßstäbe beziehungsweise relativen Abbildungsmaßstäbe:

Dies ist zwar ein einfacher Ansatz, da die Brennweiten als Kenndaten des Zoomobjektivs in der Regel angegeben werden, dieser lässt jedoch unbeachtet, dass die perspektivische Wirkung einer optischen Abbildung nicht von der Brennweite, sondern vom Bildwinkel bestimmt wird und bei Vergrößerungen der Abbildungsmaßstab einen viel entscheidenderen Einfluss hat. Bei einer Verdopplung der Brennweite ist es bei hinreichend geringer Objektweite ohne weiteres möglich, einen zehn Mal größeren Abbildungsmaßstab respektive einen zehn Mal kleineren Bildwinkel zu erreichen. Der Zoomfaktor ist also nur eine Kenngröße, die die Verhältnisse der Abbildungsmaßstäbe bei unendlicher Objektweite angeben. Für Objektweiten in der Größenordnung der Brennweite ist das Verhältnis der Abbildungsmaßstäbe beziehungsweise der Bildwinkel erheblich aussagekräftiger als der Zoomfaktor.

Die folgenden Tabelle gibt für eine Objektweite von Längeneinheiten die Verhältnisse der Brennweiten, Abbildungsmaßstäbe und Bildwinkel bei verschiedenen Brennweiten bezogen auf die Bezugsbrennweite (dies entspricht einem Abbildungsmaßstab von , einer Bildweite von , einer Bilddiagonale von , wenn die Normalbrennweite des Systems ist, und einem Bildwinkel von ) an:

Brennweite |

Bildweite |

Abbildungs- maßstab |

Bildwinkel in ° |

Verhältnis der Brennweiten |

Verhältnis der Abbildungsmaßstäbe |

Verhältnis der Bildwinkel |

|---|---|---|---|---|---|---|

| 0,999 | 1,000 | 1/1000 | 154 | 0,100 | 0,099 | 0,303 |

| 1,996 | 2,000 | 1/500 | 131 | 0,200 | 0,198 | 0,358 |

| 4,975 | 5,000 | 1/200 | 82,3 | 0,498 | 0,495 | 0,568 |

| 9,901 | 10,00 | 1/100 | 47,2 | 0,990 | 0,990 | 0,991 |

| 10,00 | 10,10 | 1/99 | 46,8 | 1,00 | 1,00 | 1,00 |

| 19,61 | 20,00 | 1/50 | 24,7 | 1,96 | 1,98 | 1,90 |

| 38,46 | 40,00 | 1/25 | 12,5 | 3,85 | 3,96 | 3,75 |

| 100 | 111,1 | 1/9 | 4,51 | 10 | 11 | 10,4 |

| 200 | 250,0 | 1/4 | 2,00 | 20 | 24,75 | 23,4 |

| 250 | 333,3 | 1/3 | 1,50 | 25 | 33 | 31,1 |

| 333 | 500,0 | 1/2 | 1,00 | 33,3 | 49,5 | 46,7 |

| 400 | 666,7 | 2/3 | 0,751 | 40 | 66 | 62,3 |

| 500 | 1000 | 1 | 0,501 | 50 | 99 | 93,4 |

| 667 | 2000 | 2 | 0,250 | 66,7 | 198 | 187 |

| 750 | 3000 | 3 | 0,167 | 75 | 297 | 280 |

| 833 | 5000 | 5 | 0,100 | 83,3 | 495 | 467 |

| 1000 | ∞ | ∞ | 0,000 | 100 | ∞ | ∞ |

Hier ist klar zu sehen, dass bei zunehmenden Bildweiten die Verhältnisse der Brennweiten von denen der Abbildungsmaßstäbe und Bildwinkel deutlich auseinanderlaufen; die Unterschiede der Abbildungsmaßstäbe und der Bildwinkel werden im Vergleich zu den Unterschieden der Brennweiten immer größer und gehen gegen Unendlich.

Anders bei kurzen Bildweiten: hier stimmen die Verhältnisse der Brennweiten gut mit denen der Abbildungsmaßstäbe überein, jedoch ist die Zunahme der Bildwinkel hierbei begrenzt, weil der maximale Bildwinkel auf 180° begrenzt ist. Das minimale Verhältnis der Bildwinkel ergibt sich folglich zu:

Ferner ist unbedingt zu beachten, dass sich insbesondere bei kompakten Objektiven mit innenliegender Fokussierung der Abbildungsmaßstab bei der Scharfstellung ändern kann, auch ohne dass die Brennweite gegebenenfalls variiert wird.

Öffnung

Bearbeiten

Die Öffnung (oder auch Apertur) eines rotationssymmetrisch konstruierten Objektivs wird durch den freien Durchmesser beschrieben, der nicht durch die mechanische Vorrichtungen wie beispielsweise Kanten, Linsenfassungen oder Blenden begrenzt ist und welcher auch als Öffnungsweite bezeichnet wird. Die virtuelle Öffnung von Objektiven kann durch das objektseitige und das bildseitige virtuelle Bild der Aperturblende beschrieben werden, die auch wirksame Eintrittspupille beziehungsweise wirksame Austrittspupille genannt wird.

Liegt die Aperturblende vor der ersten Hauptebene der Abbildung (objektseitig) ist die wirksame Eintrittspupille identisch mit der reallen Öffnung. Liegt die Aperturblende hinter der letzten Hauptebene der Abbildung (bildseitig) ist die wirksame Austrittspupille identisch mit der reallen Öffnung.

Idealerweise werden Aperturblenden in die Hauptebenen des Strahlengangs gelegt, damit sie den Bildausschnitt respektive den Bildwinkel der optischen Abbildung nicht beeinflussen. Mit einer solchen Aperturblende kann der Lichtstrom durch ein optisches System begrenzt werden. Mit variablen Aperturblenden (beispielsweise Irisblenden) kann der Lichtstrom in einem optischen System verändert werden.

Befindet sich eine Blende in der Nähe der Objektebene oder der Bildebene, handelt es sich nicht um eine Aperturblende, sondern um eine Feldblende, die den Bildausschnitt beziehungsweise den erfassten Bildwinkel unmittelbar auf die sogenannte Eintrittsluke (objektseitig) beziehungsweise Austrittsluke (bildseitig) begrenzt. Befinden sich solche Feldblenden nicht in der Nähe der Objekt- oder Bildebene, werden die entsprechenden Bilder dieser Feldblenden in der jeweiligen Ebene zur Bestimmung der effektiven Lukendurchmesser herangezogen.

Blendenzahl

BearbeitenDie dimensionslose Blendenzahl eines Objektivs mit der Brennweite und der Öffnungsweite ist wie folgt definiert:

Der Kehrwert der Blendenzahl wird als das Öffnungsverhältnis bezeichnet:

- Objektiv mit Irisblende zur Einstellung der Apertur (Brennweite 42,5 Millimeter)

-

Maximale Apertur (Blendenzahl 1,2)

-

Minimale Apertur (Blendenzahl 16)

Die Änderung der Blendenzahl um eine Blendenstufe kann sowohl durch Auf- als auch durch Abblenden erreicht werden, wobei sich die Blendenzahl um den Faktor Wurzel von zwei und der Lichtstrom im Objektiv um den Faktor zwei ändert. Je kleiner die Blendenzahl, desto mehr Licht trägt zur Abbildung bei und umgekehrt. Nach der Halbierung der Blendenzahl kommt vier Mal soviel Licht durch das Objektiv, bei der Verdopplung der Blendenzahl nur ein Viertel des Lichtes. Zwei Blendenzahlen und unterscheiden sich um die folgende Anzahl von Blendenstufen :

Blendenzahlen werden häufig mit den folgenden elf Vorzugswerten angegeben, die sich jeweils um zirka eine Blendenstufe unterscheiden und demzufolge insgesamt zehn Blendenstufen umfassen:

- 1,0 - 1,4 - 2,0 - 2,8 - 4,0 - 5,6 - 8,0 - 11 - 16 - 22 - 32

Hierbei ist zu beachten, dass die Blendenzahl ohne die Angabe der gewählten Bildgröße wenig Aussagekraft hat. Bei konstantem Bildwinkel und konstanter Öffnungsweite ist nicht nur die zur optischen Abbildung beitragenden Lichtmenge, sondern ist auch das Verhältnis zwischen Bildgröße und Bildweite konstant, obwohl die Abbildungen mit unterschiedlichem Abbildungsmaßstab beziehungsweise unterschiedlicher Brennweite und somit auch mit unterschiedlicher Blendenzahl gemacht werden.

Für die Gegebenheiten in der Abbildung rechts gilt:

Aber:

Öffnungswinkel

Bearbeiten

Der Öffnungswinkel ist der Winkel unter dem die wirksame Öffnung mit der Öffnungsweite eines Objektivs erscheint.

Von einem Objektpunkt auf der optischen Achse aus betrachtet handelt es sich um den objektseitigen Öffnungswinkel :

Der halbe objektseitige Öffnungswinkel wird auch Aperturwinkel genannt.

Von einem Bildpunkt auf der optischen Achse aus betrachtet handelt es sich um den bildseitigen Öffnungswinkel :

Der halbe bildseitige Öffnungswinkel wird auch Feldwinkel genannt.

Die Öffnungswinkel dürfen nicht mit dem Bildwinkel verwechselt werden (siehe dazu auch Bildwinkel) !

Bei unendlicher Objektweite ist die Bildweite identisch mit der Brennweite, so dass die Blendenzahl folgendermaßen ausgedrückt werden kann:

Sinusbedingungen

Bearbeiten

Die beiden Öffnungswinkel stehen für Abbildungen, bei denen Öffnungsfehler (siehe auch sphärische Aberration) keine Rolle spielen, über Sinusbedingungen in Beziehung. Im folgenden wird etwas vereinfachend davon ausgegangen, dass die optische Abbildung eines Gegenstands mit der Objektgröße in ein reelles Bild mit der Bildgröße außerhalb des optischen Systems, das durch die Hauptebene repräsentiert wird, vom gleichen optischen Medium (zum Beispiel Vakuum, Luft oder Flüssigkeit) mit konstanter Brechkraft umgeben ist.

Ein kleiner flächenhafter Gegenstand mit der Objektgröße , der senkrecht zur optischen Achse steht, kann nur dann hinreichend scharf mit der Bildgröße senkrecht zur optischen Achse abgebildet werden, wenn alle Punkte des Gegenstands beim halben objektseitigen Öffnungswinkel innerhalb einer Wellenlänge einer ebenen Welle erfasst und alle Bildpunkte beim halben bildseitigen Öffnungswinkel ebenfalls innerhalb einer Wellenlänge einer ebenen Welle zu einem Bild zusammengesetzt werden können. Durch diese Voraussetzung kann vermieden werden, dass es im Bild Interferenzen gibt, die Kontraste erzeugen, die nicht dem Aussehen des abgebildeten Gegenstands entsprechen.

Die daraus resultierende Abbesche Sinusbedingung gilt für eine in Bezug auf den Öffnungsfehler korrigierte Abbildung mit dem Abbildungsmaßstab sowie für eine bestimmte Wellenlänge (monochromatisches Licht). Sie lautet wie folgt:

Diese Sinusbedingung kann auch in der Form der Helmholtz-Lagrange-Invariante geschrieben werden:

Paraxiale Strahlengänge

BearbeitenFür paraxiale Strahlengänge können sehr kleine Öffnungswinkel angenommen werden, so dass dann die Sinūs durch die Argumente (im Bogenmaß) ersetzt werden können:

Daraus folgt:

Die paraxiale Optik, die auch gaußsche Optik genannt wird, verwendet in der geometrischen Optik diese Näherung, bei der für eine optische Abbildung nur paraxiale Strahlen berücksichtigt werden.

Schnittweite

Bearbeiten

Die auf der optischen Achse gemessenen Schnittweiten und beim Übergang an einer sphärischen Fläche mit dem Radius zwischen zwei optischen Medien mit den Brechungsindices und kann für paraxiale Strahlen leicht abgeschätzt werden. Hierbei gelten für den Grenzwert der Pfeilhöhe (siehe nebenstehende Abbildung) die folgenden Näherungsgleichungen:

Aus dem Snelliusschen Brechungsgesetz folgt für achsnahe Strahlen die Näherung:

Sowie:

Durch Kürzen der Höhe ergibt sich schließlich die Näherungsgleichung:

Dies ist die Schnittweitengleichung einer sphärischen Fläche für paraxiale Strahlen.

Sie kann auch in Form der Abbeschen Invariante geschrieben werden:

Für Objekte auf der optischen Achse mit unendlicher objektseitiger Schnittweite gilt:

In diesem Fall ergibt sich für die bildseitige Schnittweite :

Für Objekte auf der optischen Achse mit unendlicher bildseitiger Schnittweite gilt:

In diesem Fall ergibt sich für die objektseitige Schnittweite :

Dünne Linsen

Bearbeiten

Bei einer dünnen Linse ist die Dicke zwischen den Scheitelpunkten ihrer brechenden sphärischen Oberflächen auf der optischen Achse im Vergleich zu den beiden Radien dieser Oberflächen klein. Für eine dünne bikonvexe sphärische Sammellinse mit den beiden Radien und und dem Brechungsindex in einem die Linse umgebenden Medium mit dem Brechungsindex ergibt sich die folgende entsprechende Beziehung für die Schnittweiten:

Für Objekte auf der optischen Achse mit unendlicher objektseitiger Schnittweite gilt damit für die bildseitige Schnittweite :

Für Objekte auf der optischen Achse mit unendlicher bildseitiger Schnittweite gilt entsprechend für die objektseitige Schnittweite :

Bei dünnen plankonvexen sphärischen Sammellinsen mit dem Brechungsindex kann einer der beiden Radien auf Unendlich gesetzt werden. Damit ergibt sich für den verbleibenden Radius :

Die Schnittweiten entsprechen bei paraxialen Strahlen dann den Brennweiten (bildseitig bei der Abbildung aus dem Unendlichen mit ) beziehungsweise (objektseitig bei der Abbildung ins Unendliche mit ):

Befindet sich eine solche Linse in einem optisch sehr dünnen Medium wie Luft () oder im Vakuum (), vereinfacht sich diese Näherungsformel weiter zu:

Große Objektweiten

BearbeitenBei großer Objektweite ist die Bildweite annhähernd gleich der Brennweite , und der Sinus des halben objektseitigen Öffnungswinkels kann in guter Näherung durch das Verhältnis der Hälfte der Öffnungsweite und Objektweite ausgedrückt werden:

Daraus folgt:

Aus der Beziehung

folgt:

Diese Ungleichung kann auch wieder unter Verwendung der Blendenzahl ausgedrückt werden:

In Worten ausgedrückt:

Die Blendenzahl kann bei der öffnungsfehlerfreien Abbildung von Flächen aus dem Unendlichen minimal den Wert 0,5 annehmen.

Die Strecke vom Schnittpunkt der Randstrahlen mit der Hauptebene zum Bildpunkt auf der optischen Achse beträgt bei der Abbildung aus dem Unendlichen mit der Brennweite :

Mit den geometrischen Ähnlichkeiten der Dreiecke bei der Sinusbedingung ergibt sich das folgenden Verhältnis:

Da die Blendenzahl k nicht kleiner als 0,5 werden kann, gilt als Abschätzung demzufolge:

Numerische Apertur

BearbeitenDie numerische Apertur dient zur Einschätzung des Auflösungsvermögens von optischen Geräten, bei denen die Objektweite dicht bei der objektseitigen Brennweite beziehungsweise bei denen die Bildweite dicht bei der bildseitigen Brennweite liegt. Ein Anwendungsbeispiel sind Immersionsobjektive (insbesondere bei Mikroskopen), die bei der optischen Abbildung in eine hochbrechende Flüssigkeit (zum Beispiel Immersionsöl) eingetaucht werden.

Die numerische Apertur bezieht sich auf den halben Öffnungswinkel und die Brechzahl des optischen Mediums außerhalb des Objektivs. Je höher die dimensionslose Zahl der numerischen Apertur sich dem Brechungsindex des umgebenden Mediums von unten nähert, desto lichtstärker ist das verwendete Objektiv und desto höher wird bei optisch korrigierten Objektiven das optische Auflösungsvermögen.

Für die objektseitige numerische Apertur ergibt sich:

Für die bildseitige numerische Apertur ergibt sich entsprechend:

Die numerische Apertur kann also nicht größer werden als der Brechungsindex des umgebenden Mediums.

Die Sinūs der halben Öffnungswinkel können hierbei mit Hilfe der rechtwinkligen Dreiecke (siehe Skizze rechts) und des Satzes des Pythagoras sowohl objektseitig als auch bildseitig wie folgt aus dem Verhältnis von Gegenkatheten zur Hypotenusen bestimmt werden:

Bei einer Abbildung ins Unendliche () oder wird die Abbildung aus dem Unendlichen gemacht (), kann jeweils die Blendenzahl eingesetzt werden, und dann vereinfachen sich beide Gleichungen wie folgt:

Für große Blendenzahlen () gilt dann näherungsweise:

Für hinreichend große Objektweiten () beziehungsweise hinreichend große Bildweiten () gelten die folgende Näherungen:

Ist zudem auch noch die Brennweite hinreichend nah an der Objektweite () oder an der Bildweite (), dann gilt und wiederum die Näherung (siehe auch oben):

Bei einem Abbildungsmaßstab von eins (siehe unten) sind Objektweite und Bildweite identisch und genau doppelt so groß wie die verwendete Brennweite . In diesem Fall sind auch die objektseitige und die bildseitige numerische Apertur sowie der objektseitige und der bildseitige Öffnungswinkel identisch:

Modulationsübertragung

BearbeitenModulation

Bearbeiten

Die Modulation (auch Michelson-Kontrast genannt) ist ein Maß (lateinisch: modulatio) für relative Helligkeitsschwankungen zwischen zwei Bildpunkten mit den vom Menschen als Helligkeiten empfundenen Leuchtdichten und (siehe auch Kapitel Leuchtdichte), das unter den Voraussetzungen und wie folgt berechnet werden kann:

Die Modulation gibt also keineswegs den Helligkeitsunterschied

zwischen zwei Bildpunkten an, sondern setzt diesen in Bezug auf die Summe dieser beiden Helligkeiten, die auch als der doppelte Mittelwert, also

- ,

der beiden Helligkeiten interpretiert werden kann:

Dies bedeutet, dass die maximale Modulation den Wert eins hat, die genau dann erreicht wird, wenn ist und der dunklere Punkt also keine Helligkeit (die Leuchtdichte null) hat. Die absolute Helligkeit des helleren Bildpunktes hat in diesem Fall keinen Einfluss auf die Modulation. Die Helligkeitsdifferenz zwischen diesen beiden Bildpunkten ist in Bezug auf die Helligkeit des helleren Punktes dann maximal und exakt genauso groß wie diese.

Wenn beide Bildpunkte die gleiche Helligkeit größer als null haben , so ergibt sich immer eine Modulation von null (wenn beide Punkte keine Helligkeit haben, ist die Modulation nicht definiert).

Werden beide Helligkeiten um denselben Faktor verändert, bleibt die Modulation erhalten:

Da innerhalb eines Bildes üblicherweise mehr als zwei Bildpunkte vorhanden sind, ist es meist von Interesse, in welchem Verhältnis der hellste Bildpunkt (Weißwert) und der dunkelste Bildpunkt (Schwarzwert) zueinander stehen, was durch die maximale Modulation bestimmt werden kann:

Es gilt zu beachten, dass bei einem Schwarzwert von einem Drittel des Weißwertes die Modulation nur noch 50 Prozent und bei einem Schwarzwert von der Hälfte des Weißwertes nur noch 33 Prozent beträgt.

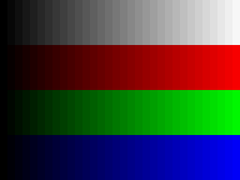

Die Modulation kann in farbigen Bildern für jede einzelne Farbe unabhängig bestimmt werden. Bei den drei Primärfarben rot, grün und blau (R, G, B) eines Bildpunktes ergeben sich dann also entsprechend:

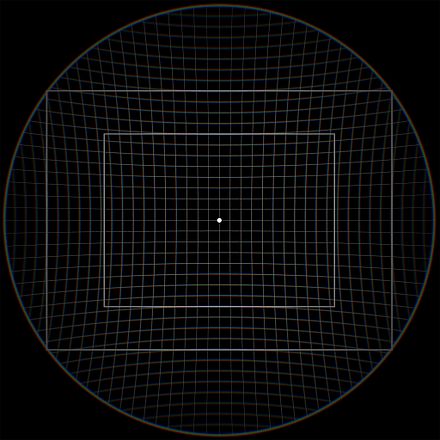

Ortsfrequenz

BearbeitenDie Ortsauflösung entspricht der maximalen Anzahl von räumlichen Informationseinheiten, die entlang einer Strecke, meist der Bildhöhe beziehungsweise der Bildbreite, erfasst werden können. Zur Darstellung einer räumlichen Information, also eines Helligkeitswechsels, ist mindestens ein Bildpunktpaar erforderlich, damit eine Modulation vorhanden sein kann.

Die Bezugslänge kann eine absolute Länge sein, bei der die Bildpunktpaare zum Beispiel pro Millimeter ermittelt werden. Bei Filmmaterial wurde diese Informationsdichte meist richtungsunabhängig in Linienpaaren pro Millimeter ermittelt und angegeben.

Auf der anderen Seite kann statt einer metrischen Bezugslänge auch eine relative Bezugslänge gewählt werden, wie zum Beispiel die Bilddiagonale, die Bildbreite oder die Bildhöhe. Dieses Vorgehen hat den Vorteil, dass unabhängig von der Gesamtzahl der Bildpunkte, der Größe der Reproduktion des Bildes und dem Bildseitenverhältnis ein einheitliches und somit leicht vergleichbares Maß für die Ortsauflösung zur Verfügung steht. Dieses Maß ist insbesondere unabhängig von der Größe und vom Bildseitenverhältnis des verwendeten Bildsensors. Bei digitalen Bildern hat es sich daher durchgesetzt, Linienpaare pro Bildhöhe (horizontale Linien) als Bezugsgröße zu verwenden. Diese Bezugsgröße wird dann ebenfalls für die Informationseinheiten in horizontaler Richtung (vertikale Linienpaare) oder für jeden beliebigen anderen Azimut (also schräg liegende Linienpaare) verwendet, obwohl bei rechteckigen Bildformaten in horizontaler Richtung mehr oder weniger Informationseinheiten zur Verfügung stehen können. Rechnerisch ergibt sich die maximal darstellbare Linienauflösung durch die Halbierung der Anzahl der Punkte in der Bildhöhe :

Für die maximale Anzahl vertikaler Linienpaare in horizontaler Richtung ergibt sich mit dem Bildseitenverhältnis dann entsprechend:

Siehe hierzu auch: Bildseitenverhältnis

Dieser Wert entspricht genau der Grenze nach dem Nyquist-Shannon-Abtasttheorem (auch Whittaker-Kotelnikow-Shannon-Abtasttheorem) für die maximal darstellbaren Ortsfrequenzen , wonach diese innerhalb einer Periode mindestens zwei abgetastete Stützstellen haben müssen:

Aus einer beliebigen kleineren Ortsfrequenz ergibt sich die maximal mögliche Häufigkeit von Helligkeitsunterschieden auf einer bestimmten Bezugslänge im Bild (also in der Regel auf der Bildhöhe).

Eine Ortsfrequenz von null entspricht einer konstanten Helligkeit über das gesamte Bild, die selbst nicht notwendigerweise den Wert null haben muss.

Modulation in Abhängigkeit von der Ortsfrequenz

Bearbeiten

Eine Modulation mit geringer Ortsfrequenz entspricht also groben Strukturen im Bild, und eine Modulation mit großer Ortsfrequenz entspricht feinen Strukturen im Bild. Jeder Struktur mit einer bestimmten Größe kann in jeder azimutalen Richtung (nicht nur horizontal oder vertikal, sondern auch in beliebiger schräg liegender Richtung) eine Ortsfrequenz mit einer bestimmten Modulation zugeordnet werden.

Beim Siemensstern wird beispielsweise die Ortsfrequenz entlang der um den Mittelpunkt liegenden konzentrischen Kreise linear mit deren Radius größer. Die Modulation beträgt für jede Ortsfrequenz eins, wenn idealisiert davon ausgegangen wird, dass die dunklen Streifen keine Helligkeit aufweisen.

Wird eine photographische Aufnahme von einem solchen Siemensstern als Objekt auf einer Testtafel gemacht, reduzieren sich im Bild die Modulationen für alle Ortsfrequenzen größer als null auf Werte kleiner als eins. Dies beruht auf einer Verminderung der Modulationen im Bild gegenüber der optimalen Modulation im Objektraum, die durch Abbildungsfehler bedingt ist. Neben der immer wirkenden Beugungsbegrenzung ergeben sich in optischen Abbildungen vor allem durch die sphärische Aberration, aber zum Beispiel auch durch Falschlicht Einbußen bei der Modulation im Bildraum.

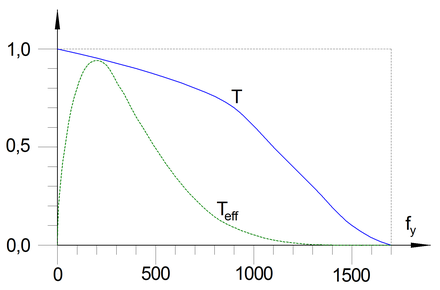

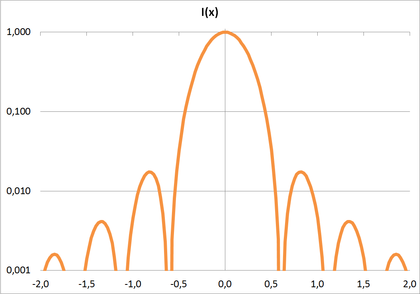

In der Regel führt dies dazu, dass die Modulation von rein optischen Abbildungen mit zunehmender Ortsfrequenz streng monoton und stetig abnimmt. Das Verhältnis der Modulation im Bildraum zur Modulation im Objektraum in Abhängigkeit von der Ortsfrequenz wird Modulationsübertragungsfunktion (englisch: modulation transfer function = MTF) oder auch Kontrastübertragungsfunktion genannt:

Das Maximum der Modulationsübertragungsfunktion liegt bei optischen Systemen bei der kleinsten Ortsfrequenz, also null, und hat dort den Wert eins. Die Modulationsübertragung ist dabei immer der Betrag der komplexwertigen optischen Übertragungsfunktion, die nicht nur die Amplitude, sondern auch die Phase der übertragenen Lichtwellen berücksichtigt.

Ist die Modulation im Objektraum für alle untersuchten Ortsfrequenzen gleich eins, wie zum Beispiel bei hochwertig hergestellten Testtafeln, sind die Modulationsübertragungsfunktion und die Modulation im Bildraum identisch:

- , wenn

Der Betrag der komplexwertigen, zweidimensionalen Fourier-Transformation der Bilddaten im Bildraum kann zur Ermittlung der spektralen Dichte der Modulationsübertragungsfunktion im Ortsfrequenzraum herangezogen werden. In der digitalen Signalverarbeitung wird hierfür häufig die sehr effiziente Fast-Fourier-Transformation (FFT) eingesetzt. Das Leistungsdichtespektrum der Fourier-Transformierten entspricht hierbei dem Beugungsbild der Bilddaten, das mit einer Bildwand aufgefangen werden kann.

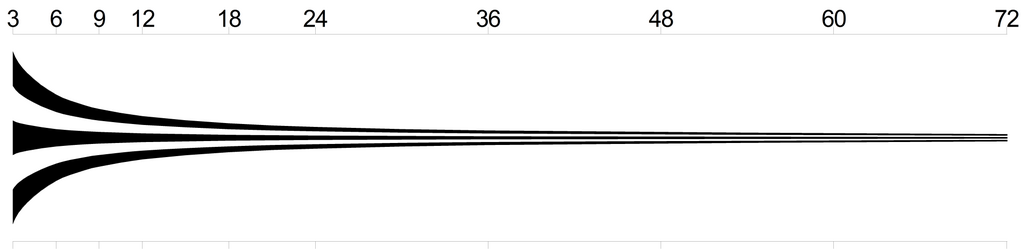

- Auflösungskeile mit 3 bis 72 Linienpaaren pro Bildhöhe mit verschiedenen Kontrastübertragungen, die Bildhöhe wird zwischen den beiden dünnen horizontalen Linien ober- und unterhalb des Auflösungskeils gemessen.

-

Maximaler Kontrast (852 Linienpaare pro Bildhöhe).

-

Kontrast bis 72 Linienpaare pro Bildhöhe.

-

Kontrast bis 36 Linienpaare pro Bildhöhe.

-

Kontrast bis 18 Linienpaare pro Bildhöhe.

-

Kontrast bis 9 Linienpaare pro Bildhöhe.

Weitere Beispiele siehe auch Fourier-Transformation.

Kontrastempfindlichkeitsfunktion

Bearbeiten

Zu den Kontrastverhältnissen beim durch den Erdschein beleuchteten aschgrauen Mondlicht siehe auch hier: Kontrastverhältnisse bei aschgrauem Mondlicht

Oben:fünffache Vergrößerung (500 Prozent)

Unten: einfache Vergrößerung (100 Prozent)

Für die Betrachtung der optischen Abbildungen durch Menschen ist nur der Bereich der Ortsfrequenzen interessant, der entsprechend der Contrast Sensitivity Function (CSF, zu Deutsch: Kontrastempfindlichkeitsfunktion) überhaupt wahrgenommen werden kann. Oft wird jedoch die Modulation an der Nyquist-Frequenz als Maß für die wahrnehmbare Qualität einer optischen Abbildung herangezogen. Dieses Vorgehen trägt jedoch nicht dem Umstand Rechnung, dass die vom Betrachter empfundene Qualität einer optischen Abbildung im Sinne der Modulationen bei verschieden feinen Strukturen im allgemeinen gar nicht von der Modulation bei der Nyquist-Frequenz bestimmt ist, insbesondere wenn die feinsten Strukturen mit bloßem Auge gar nicht aufgelöst werden können. Vielmehr kommt es meist auf eine möglichst große Modulation bei Ortsfrequenzen im mittleren Bereich an. Dies kann zu der zunächst paradox scheinenden Situation führen, dass die optische Abbildung mit einem Objektiv, dass bei der Nyquist-Frequenz die gleiche oder gar eine höhere Modulation aufweist als ein anderes Objektiv, subjektiv dennoch als schlechter beurteilt wird (vergleiche Abbildung rechts).

Daher ist es empfehlenswert, die integrale Summe der Modulationen aller Ortsfrequenzen bis zu einer sinnvollen maximalen Ortsfrequenz zu bilden. Dieser Wert wird auch Heynacher-Zahl genannt, die seit den 1970er Jahren nach dem Optiker Erich Heynacher benannt ist. Gegebenenfalls kann diese integrale Summe auch noch bei verschiedenen Ortsfrequenzen mit einer geeigneten Empfindlichkeitsfunktion gewichtet werden (mathematisch also eine Faltung). Je größer das Integral der Modulationsübertragungsfunktion, desto besser die Bildqualität.

Der Betrag der komplexwertigen Spektralfunktion der zweidimensionalen Fourier-Transformation der Bilddaten im Bildraum kann zur Ermittlung der Modulationsübertragungsfunktion im Ortfrequenzraum herangezogen werden.

Die einheitenlose Kontrastempfindlichkeitsfunktion kann nach Kresimir Matkovic (1997) in Abhängigkeit von der Ortsfrequenz in Linienpaaren pro Grad mit einer analytischen Funktion angegeben werden:

Der vertikale Bildwinkel beträgt bei Normalbrennweite und einem Bildseitenverhältnis von 3 zu 2 (wie zum Beispiel beim Kleinbildfilm) 27 Grad. Die Ortsfrequenz in Linienpaaren pro Bildhöhe ergibt sich dann aus dem vertikalen Bildwinkel und der Ortsfrequenz in Linienpaaren pro Grad wie folgt:

- Kontrastempfindlichkeitsfunktion (englisch: Contrast Sensitivity Function) CSF des menschlichen Auges über der Ortsfrequenz

-

Über der Ortsfrequenz in Linienpaaren pro Grad

-

Über der Ortsfrequenz in Linienpaaren pro Bildhöhe bei Normalbrennweite (vertikaler Bildwinkel = 27° bei einem Bildseitenverhältnis von 3 zu 2)

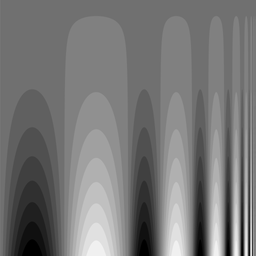

- Zur Kontrastempfindlichkeitsfunktion des menschlichen Auges mit den Ortsfrequenzen von 2 sinusmodulierten Linienpaaren pro Bildbreite (linke Bildhälfte) bis hin zu 1024 Linienpaaren pro Bildbreite (rechts am Bildrand), Bildgröße 3860 mal 2160 Bildpunkte (16:9)

-

Mit maximalem Kontrast unten, ohne Kontrast oben

-

Mit reduziertem Kontrast unten, ohne Kontrast oben

Hierbei ist festzuhalten, dass bei einer Ortsfrequenz von 1000 Linienpaaren pro Bildhöhe der wahrgenommene Kontrast deutlich unter zehn Prozent liegt und somit praktisch kaum noch relevant ist. Die maximale Kontrastempfindlichkeit liegt beim menschlichen Auge bei zirka 200 Linienpaaren pro Bildhöhe und zwischen 50 und 550 Linienpaaren pro Bildhöhe beträgt die Kontrastempfindlichkeit mindestens 50 Prozent. Für Aufnahmen mit guter Kontrastübertragung ist daher genau dieser Bereich von besonderer Wichtigkeit. Zur Auswertung der effektiven Kontrastübertragungsfunktion bei Betrachtung mit dem menschlichen Auge können die Kontrastübertragungsfunktion und die Kontrastempfindlichkeitsfunktion miteinander multipliziert werden:

Wird dieses Produkt über alle Ortsfrequenzen integriert, ergibt sich - ähnlich wie bei und als Verallgemeinerung der Heynacher-Zahl - eine Größe für die totale effektive Kontrastübertragung :

Siehe auch Kontrastverhältnisse bei aschgrauem Mondlicht.

Digitalzoom

BearbeitenBeim Digitalzoom, das heißt also bei der softwaretechnischen Vergrößerung von digitalen Bildern zum Beispiel durch Zeilen- und Spaltenverdopplung, wird die Bildinformation im Sinne der Kontrastübertragung nicht vermehrt, da es sich lediglich um das Kopieren bereits vorhandener Bildinformation handelt. Es gibt also keinen Informationsgewinn. Wenn das digitale Bild zu klein dargestellt wird, so dass ein menschlicher Betrachter das Bild nicht voll auflösen kann, kann durch den Digitalzoom das Bild insgesamt vergrößert werden, oder ein beliebiger Ausschnitt des originalen Bildes kann auf die maximal darstellbare Größe gebracht werden, die beispielsweise durch ein Anzeigegerät oder ein Druckformat vorgegeben ist. Dadurch wird zwar nicht die Bildinformation vergrößert, aber der Betrachter kann mehr von der existierenden Bildinformation erkennen.

Die Frage, welcher Digitalzoomfaktor noch sinnvoll und angebracht ist, hängt bei menschlichen Betrachtern allein von der möglichst guten Ausschöpfung der erkennbaren Modulationen ab, die durch die Kontrastempfindlichkeitsfunktion repräsentiert wird. Bei digitaler maschineller Auswertung besteht diese Problematik nicht, da ein digitaler Algorithmus in der Regel immer die gesamte Bildinformation auswerten kann.

In Unterkapitel MTF-Simulation wird der Effekt des Digitalzooms simuliert und bildlich verdeutlicht.

Siehe auch Kapitel Digitale Bilder: Digitalzoom - Softwarelupe.

Kantenüberhöhung

Bearbeiten

Bei digitalen Bildern, die nicht im Rohdatenformat, also ohne rechnerische Eingriffe in die Bilddaten, aufgezeichnet werden, wird die Modulation unmittelbar nach der Aufnahme und vor dem Speichern der Bilddaten oft durch die Firmware der Kamera insgesamt oder insbesondere bei bestimmten Ortsfrequenzen erhöht. In Maßen angewendet führt dies bei digitalen Bildern in der Regel zu einem verbesserten visuellen Bildeindruck. Dies trifft dann zu, wenn die maximale Modulation auf eins erhöht wird und die Modulation entsprechend der Kontrastempfindlichkeitsfunktion des menschlichen Auges bei den wichtigsten Ortsfrequenzen angehoben wird.

In der Modulationsübertragungsfunktion spiegelt sich dies durch die Tatsache wider, dass die maximale Modulation nicht mehr bei der Ortsfrequenz null, sondern bei positiven Ortsfrequenzen auftritt (siehe Abbildung rechts). Dies kann auch so interpretiert werden, dass die Modulation an Kanten in einem günstigen Ortsfrequenzbereich künstlich überhöht wird. Aus einem in der unbearbeiteten optischen Abbildung kontinuierlichen Anstieg der Helligkeit an einer im Original beliebig scharfen Objektkante ergibt sich nach der Optimierung bei einer bestimmten Ortsfrequenz eine deutlich stärkere Modulation.

Wird dieses Prinzip so stark angewendet, dass die Modulation bei mittleren Ortsfrequenzen dominiert, führt dies unter Umständen zu künstlich wirkenden Bildern, bei denen ein Überschwingen des Helligkeitsverlaufs an Kanten mit der entsprechenden Ortsfrequenz erkannt werden kann:

- Vergleich mit unterschiedlichen gerechneten Kontrastübertragungsfunktionen

-

Unbearbeitetes Originalbild

-

Bild mit rechnerisch angepasster Modulation bei mittleren Ortsfrequenzen

-

Bild mit übertrieben verstärkter Modulation bei mittleren Ortsfrequenzen

-

Zentraler Ausschnitt vom unbearbeiteten Originalbild

-

Zentraler Ausschnitt vom Bild mit rechnerisch angepasster Modulation bei mittleren Ortsfrequenzen - der Buchstabe hat außen einen kleinen hellen und innen einen kleinen dunklen Saum

-

Zentraler Ausschnitt vom Bild mit übertrieben verstärkter Modulation bei mittleren Ortsfrequenzen - der Buchstabe hat einen großen hellen Saum, und der innere Rand des Buchstabens ist stark abgedunkelt

-

Spektrale Leistungsdichte der Modulation des zentralen Ausschnittes vom unbearbeiteten Originalbild (die Ortsfrequenz null befindet sich in der Bildmitte, und sie nimmt radial in alle Richtungen zu)

-

Spektrale Leistungsdichte der Modulation des zentralen Ausschnittes vom Bild mit rechnerisch angepasster Modulation bei mittleren Ortsfrequenzen

-

Spektrale Leistungsdichte der Modulation des zentralen Ausschnittes vom Bild mit übertrieben verstärkter Modulation bei mittleren Ortsfrequenzen

Farbauflösung

BearbeitenDurch die im Vergleich zur Dichte der für die Helligkeitsrezeption zuständigen Stäbchen geringere Dichte von Farbzäpfchen auf der menschlichen Netzhaut ist die Farbauflösung, die für das Betrachten von farbigen Bildern erforderlich ist, geringer als die Auflösung, die durch die Kontrastübertragungsfunktion beschrieben wird. In einem digitalen Bild kann ein Mensch bei Betrachtung des gesamten Bildes zwar maximal vier Millionen Bildpunkte in der Helligkeit unterscheiden, jedoch nur etwa eine Million verschiedener Farbpunkte. Bei technischen Anwendungen mit digitaler Auswertung der Bilder, kann die Anforderung an die Farbauflösung je nach Aufgabenstellung jedoch erheblich höher sein.

|

|

|

|

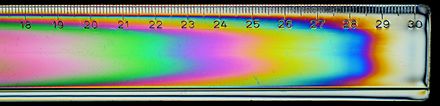

Eine Möglichkeit, die Farbauflösung eines Kamerasensors zu messen, ohne dass es durch das für die optische Abbildung verwendete Objektiv zu einer Verringerung derselben kommt, ist die Verwendung eines direkt auf den Bildsensor projizierten Weißlichtinterferogramms. Dieses Verfahren wurde 2006 von Karsten Zoellner vom Institut für angewandte Optik an der Universität Jena entwickelt. Der Linienabstand des Beugungsbilds eines Spaltes hängt von der Wellenlänge des verwendeten Lichtes sowie vom bildseitigen Öffnungswinkel des verwendeten Interferometers ab:

Wenn für die Primärfarben Rot, Grün und Blau (RGB) die mit abnehmender Wellenlänge kleiner werdenden Linienabstände , und bestimmt werden, kann daraus eine für die Farbauflösung repräsentative Größe , die Farbstrukturtreue (englisch: coloured structure fidelity), bestimmt werden:

Beleuchtung

BearbeitenDieses Kapitel beschäftigt sich mit Themen, die im Zusammenhang mit der Beleuchtung von Objekten (synonym für "von Gegenständen"), die betrachtet oder photographisch abgebildet werden sollen, von Bedeutung sind.

Photonen

BearbeitenPhotonen sind die Ausprägung von elektromagnetischer Strahlung als Teilchen. Sie breiten sich in allen optischen Medien wellenartig aus. Das Produkt aus der Schwingungsfrequenz der elektromagnetischen Welle und deren Wellenlänge ist die Lichtgeschwindigkeit :

Die Vakuumlichtgeschwindigkeit hat eine festgelegte Größe:

In allen anderen optischen Medien ist die Lichtgeschwindigkeit um den Zahlenfaktor kleiner als im Vakuum:

- beziehungsweise

Der einheitenlose Zahlenfaktor wird Brechzahl oder Brechungsindex genannt. Er beträgt für das Vakuum Eins.

Bei elektromagnetischer Strahlung mit der Wellenlänge respektive der Frequenz ergibt sich die Photonenenergie (Maßeinheit Joule, abgekürzt: J) aus der Beziehung:

- ,

wobei für das Plancksche Wirkungsquantum steht.

Der mechanische Impuls eines Photons ist umgekehrt proportional zu dessen Wellenlänge beziehungsweise proportional zu dessen Energie :

Photometrische Grundbegriffe

BearbeitenPhotonenstrom

BearbeitenDie Photonenmenge respektive Strahlungsmenge (für Quantität) ist ein einheitenloses Maß für die Anzahl der Photonen mit einer bestimmten Energie (respektive mit einer bestimmten Wellenlänge oder mit einer bestimmten Frequenz). Der Photonenstrom (Maßeinheit 1/s) ergibt sich aus der in einer bestimmten Zeit untersuchten Photonenmenge:

Strahlungsleistung

BearbeitenDie Strahlungsleistung (auch Strahlungsfluss genannt, Maßeinheit Watt, abgekürzt: W, Index e für "elektromagnetisch") ergibt sich bei monochromatischer elektromagnetischer Strahlung wiederum aus dem Produkt von Photonenstrom und der Energie eines einzelnen Photons mit der Wellenlänge .

Entsprechend ergibt sich für die Strahlungsenergie :

Sowie für die Strahlungsstromdichte (auch Bestrahlungsstärke, siehe unten) senkrecht durch eine Fläche :

Photonen, die mit dem Photonenstrom im Winkel zum Oberflächenlot auf eine Fläche treffen, erzeugen dort den mechanischen Strahlungsdruck :

Für monochromatisches Licht mit den Photonenstrom aus Photonen mit dem mechanischen Impuls gilt demnach:

Lichtstrom

BearbeitenDer Lichtstrom (Index v für "visuell", also elektromagnetische Strahlung im sichtbaren Wellenlängenbereich zwischen etwa 380 und 780 Nanometer) ergibt sich aus der Multiplikation der elektromagnetischen Strahlungsleistung mit dem entsprechenden wellenlängenabhängigen photometrischen Strahlungsäquivalent :

Das spektrale photometrische Strahlungsäquivalent hat die Maßeinheit Lumen pro Watt, so dass für den Lichtstrom die Maßeinheit Lumen (abgekürzt: lm, lateinisch: Leuchte) resultiert.

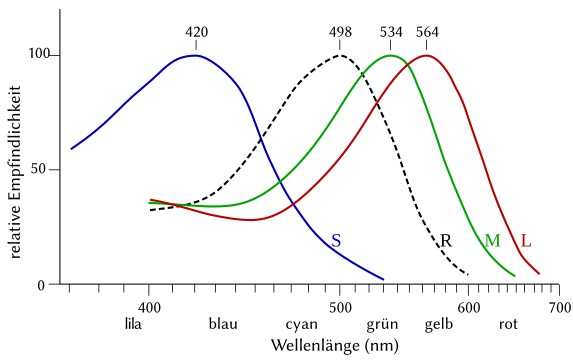

Bezogen auf die spektrale Empfindlichkeit der menschlichen Netzhaut müssen das farbige Tagesehen (photopisches Sehen) mit den Zapfen und das monochrome Nachtsehen (skotopisches Sehen) mit den Stäbchen unterschieden werden. Die entsprechenden photometrischen Strahlungsäquivalente sind in der DIN 5031 festgelegt: das maximale photometrische Strahlungsäquivalent für das Tagsehen beträgt 683,002 Lumen pro Watt, und das maximale photometrische Strahlungsäquivalent für das Nachtsehen beträgt 1700,13 Lumen pro Watt (vergleiche CIE 191:2010 Recommended System for Mesopic Photometry based on Visual Performance, International Commission on Illumination (CIE), Wien).

Mit der physiologischen, wellenlängenabhängigen und einheitenlosen Bewertungsfunktion des menschlichen Auges (auch Hellempfindlichkeitskurve oder relativer spektraler Hellempfindlichkeitsgrad) sowie für das spektrale photometrische Strahlungsäquivalent in Lumen pro Watt ergibt sich für das Tagsehen:

Und für das Nachtsehen mit der entsprechenden Bewertungsfunktion beziehungsweise mit dem spektralen photometrischen Strahlungsäquivalent in Lumen pro Watt:

Die Lichtmenge beim Tagsehen und beim Nachtsehen kann für monochromatisches Licht der Wellenlänge also als Funktion des Lichtstroms ausgedrückt werden:

Bei grünem Licht ( = 550 Nanometer) mit einem Lichtstrom von einem Lumen sind in jeder Nanosekunde beim Tagsehen demzufolge rund vier Millionen Photonen beteiligt.

Der Wirkungsgrad einer Lichtquelle kann durch das Verhältnis des Lichtstroms mit der für die Lichterzeugung aufgewendeten Leistung beschrieben werden, das auch Lichtausbeute genannt wird (Maßeinheit Lumen pro Watt):

- Wahrnehmung von elektromagnetischer Strahlung durch Menschen

-

Relative Hellempfindlichkeitskurven für das Tagsehen V(λ) (rot) und für das Nachtsehen V'(λ) (blau).

-

Spektrale Empfindlichkeit der drei Zapfentypen in der menschlichen Netzhaut (S, M, L) über der Lichtwellenlänge. Der Unterschied zwischen L und M liegt vor allem bei den roten und grünen Wellenlängen, und S reagiert vor allem auf die Wellenlängen im blauen Bereich.

-

Spektrale Empfindlichkeit der drei Zapfentypen und der Stäbchen in der menschlichen Netzhaut über der Lichtwellenlänge in Nanometern (nm). Die maximale Empfindlichkeit der drei Zapfentypen liegt bei den Farben ⬤ (420 nm, violett), ⬤ (534 nm, grün) und ⬤ (564 nm, gelbgrün).

-

Spektrales photometrisches Strahlungsäquivalent für Tagsehen K(λ) und für Nachtsehen K′(λ).

Beleuchtungsstärke

Bearbeiten

Wird ein Lichtstrom auf eine entsprechende definierte geometrische Fläche projiziert, kann die Beleuchtungsstärke der Projektion innerhalb dieser Fläche ermittelt werden:

Für eine kreisförmige Projektionsfläche mit dem Durchmesser gilt demzufolge:

Emittiert die definierte geometrische Fläche einer Lichtquelle einen Lichtstrom, wird von der spezifischen Lichtausstrahlung (also eigentlich eine Leuchtstärke) dieser Fläche gesprochen, die sich entsprechend berechnet:

Für einen kreisförmigen Emitter mit dem Durchmesser gilt demzufolge:

Die Beleuchtungsstärke und die spezifische Lichtausstrahlung stellen also eine Lichtstromdichte dar und haben die Maßeinheit Lumen pro Quadratmeter, was meist mit der Maßeinheit Lux (lateinisch: Licht, abgekürzt: lx) abgekürzt wird.

Die Beleuchtungsstärke kann unmittelbar mit einem Messgerät mit definierter Messfläche, einem sogenannten Luxmeter, ermittelt werden.

Bestrahlungsstärke

BearbeitenDie Bestrahlungsstärke ist das photometrische Äquivalent der visuellen Beleuchtungsstärke für das gesamte elektromagnetische Spektrum. Im Gegensatz zur Beleuchtungsstärke als eine Lichtstromdichte mit der Maßeinheit Lumen pro Quadratmeter hat die Bestrahlungsstärke als eine Strahlungsstromdichte die Maßeinheit Watt pro Quadratmeter. Sie ist wie folgt definiert:

Die Bestrahlungsleistung innerhalb einer definierten Messfläche kann mit unmittelbar einem sogenannten Powermeter (Leistungsmessgerät) ermittelt werden. Aus dem Verhältnis von gemessener Leistung und Messfläche ergibt sich dann rechnerisch die Bestrahlungsstärke.

Entsprechend ergibt sich für die spezifische Ausstrahlung einer Strahlungsquelle mit der Strahlungsleistung und der emittierenden Fläche die folgende Beziehung:

Raumwinkel

BearbeitenDer Raumwinkel (Maßeinheit Steradiant, abgekürzt: sr, Kunstwort aus griechisch στερεό für Körper und lateinisch radiant für sie strahlen) ist ein Maß für die Ausdehnung eines flächenhaften Objektes in Winkelkoordinaten.

In der Astronomie wird der Raumwinkel häufig in der Maßeinheit Quadratgrad (abgekürzt: deg²) angegeben:

Raumwinkel eines Kreiskegels

Bearbeiten

Der kanonische Raumwinkel eines geraden Kreiskegels kann leicht aus dem Öffnungswinkel oder aus dem Verhältnis der bestrahlten oder strahlenden, kreisrunden Mantelfläche eines Kugelsegments zu ihrem Quadratradius berechnet werden:

Siehe hierzu auch: Öffnungswinkel

Emittiert eine Lichtquelle in den gesamten Raumwinkel oder wird ein Punkt aus dem gesamten Raumwinkel beleuchtet (der Öffnungswinkel beträgt dann 360° beziehungsweise ), dann ist der Wert des Raumwinkels maximal, nämlich:

Die Radien der Kugelsegmente und können hierbei wie folgt aus dem Durchmesser der emittierenden Fläche beziehungsweise aus dem Durchmesser der projizierten Fläche und dem Abstand zwischen der ebenen Grundfläche und Scheitelpunkt des Kugelsegments bestimmt werden:

beziehungsweise

Die Mantelflächen der dazugehörigen Kugelsegmente und ergeben sich dann zu:

beziehungsweise

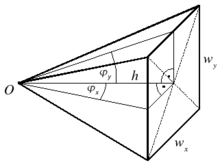

Raumwinkel einer rechteckigen Pyramide

Bearbeiten

Falls der Raumwinkel senkrecht zur optischen Achse nicht kreisrund, sondern rechteckig begrenzt ist, kann er mit den Pyramidengrundseiten und sowie der Pyramidenhöhe berechnet werden:

Alternativ können auch die beiden senkrecht aufeinander stehenden Öffnungswinkel und verwendet werden, um den Raumwinkel zu berechnen:

Lichtstärke

BearbeitenSoll die Emission von einer punktförmigen Lichtquelle oder die Beleuchtung eines Punktes beschrieben werden, wird in der Photometrie der Lichtstrom auf den Raumwinkel des Punktes der Lichtemission beziehungsweise des Punktes des Lichteinfalls bezogen, so dass die Lichtstärke mit der Maßeinheit Lumen pro Steradiant resultiert, die in der Regel durch die Maßeinheit Candela (lateinisch: Kerze, abgekürzt: cd) ausgedrückt wird:

Eine herkömmliche Haushaltskerze emittiert praktisch fast in den gesamten Raumwinkel und hat eine Lichtstärke von zirka einem Candela. Der Lichtstrom einer solchen Kerze beträgt somit:

Leuchtdichte

BearbeitenSoll die Emission von einer flächenhaften Lichtquelle mit der Fläche in den Raumwinkel oder die Beleuchtung einer Fläche aus dem Raumwinkel beschrieben werden, wird in der Photometrie die Leuchtdichte verwendet, die gemeinhin als Helligkeit interpretiert wird. Bei senkrechter Beobachtung der zu untersuchenden Fläche ergibt sich die Leuchtdichte mit der Maßeinheit Candela pro Quadratmeter beziehungsweise Lux pro Steradiant oder im englischsprachigen Raum auch abgekürzt mit Nit (vom lateinischen Verb "nitere", zu Deutsch "leuchten").

Für emittierende Flächen gilt:

Und für beleuchtete Flächen entsprechend:

Bei konstantem Lichtstrom innerhalb einer optischen Abbildung nimmt die Lichtstärke mit steigendem Abbildungsmaßstab zu, wohingegen die Beleuchtungsstärke mit steigendem Abbildungsmaßstab abnimmt. Siehe auch Abbildungsmaßstab.

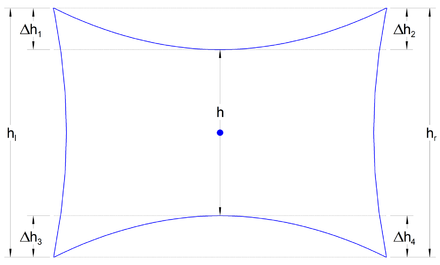

Die Leuchtdichte ändert sich durch eine geometrischen Abbildung jedoch nicht, sie wird in der Regel jedoch durch die Absorption oder Zerstreuung in den dafür erforderlichen optischen Komponenten etwas vermindert. Die Invarianz der Leuchtdichte bei optischen Abbildungen wird mit Hilfe der folgenden Skizze deutlich:

Die Flächen von Emitter (links) und Projektion P (rechts) ergeben sich aus ihren quadratischen Flächen, die durch die Objektgröße und die Bildgröße bestimmt sind:

Die kreisförmige Querschnittsfläche in der Hauptebene der optischen Abbildung (blau) ergibt sich aus deren Durchmesser :

Damit können unter Berücksichtigung der Objektweite und der Bildweite die beiden entsprechenden Raumwinkel bestimmt werden:

Die Leuchtdichten des Emitters und in der Projektion lauten:

Der Lichtstrom bleibt erhalten, wenn bei der optischen Abbildung kein Licht absorbiert wird.

Sowohl die Bildweite als auch die Bildgröße können durch den Abbildungsmaßstab ausgedrückt werden, wenn dieser auf die Objektweite und die Objektgröße angewendet wird:

Eingesetzt für die Leuchtdichte in der Projektionsebene ergibt sich schließlich:

Die Leuchtdichte in der Projektionsebene ist also mit der Leuchtdichte des abgebildeten Objekts identisch, und insbesondere ist die Leuchtdichte in der Projektionsebene unabhängig vom Abbildungsmaßstab .

Aus der Beziehung zwischen zwei verschiedenen Leuchtdichten kann ein Kontrastwert bestimmt werden. Siehe auch Modulation.

Geometrischer Fluss

BearbeitenDas Verhältnis aus Lichtstrom und Leuchtdichte wird manchmal auch als geometrischer Fluss oder als Lichtleitwert bezeichnet:

Abstandsgesetz

BearbeitenDas Verhältnis einer zusammenhängenden Teilfläche der Kugeloberfläche zum Quadrat des Kugelradius entspricht dem Raumwinkel dieser Teilfläche, der von Mittelpunkt dieser Kugel umfasst wird, in der Maßeinheit Streradiant:

- beziehungsweise

Die Oberfläche einer Kugel ergibt sich aus:

Daraus folgt unmittelbar, dass die gesamte Kugel von ihrem Mittelpunkt aus gesehen den vollen Raumwinkel von Steradiant umfasst.

- Zum Abstandsgesetz

-

Zwei Kugeln mit dem Verhältnis der Radien .

-

Zwei Kugelausschnitte unter dem Raumwinkel mit dem Verhältnis der Radien und dem Verhältnis der Oberflächen .

Wird eine beliebige Teilfläche auf einer Kugel mit dem Radius mit radialen Strahlen auf eine konzentrische Kugel mit doppeltem Radius projiziert, ergibt sich, dass der Raumwinkel erhalten bleibt, die projizierte Teilfläche auf der Kugel mit dem doppelten Radius jedoch vier Mal so groß ist wie die Teilfläche auf der Kugel mit dem einfachen Radius .

Photometrische Größen, die sich geometrisch ausschließlich auf den Raumwinkel beziehen, sind für solche Teilflächen invariant, wie zum Beispiel die Lichtstärke :

Diejenigen photometrischen Größen, die sich bei konstantem Raumwinkel jedoch auf eine vom Radius abhängige Fläche

beziehen, wie zum Beispiel die Beleuchtungsstärke , verhalten sich bei verändertem Abstand von der Lichtquelle (und bei somit verändertem Radius) umgekehrt proportional zu den Teilflächen auf den jeweiligen Kugeloberflächen und gleichzeitig umgekehrt proportional zu den Quadraten der dazugehörigen Kugelradien. Dieser Sachverhalt wird durch das Abstandsgesetz beschrieben:

Belichtung

BearbeitenDie Belichtung ist ein Maß für die Beleuchtungsstärke während der Belichtungszeit . Im allgemeinen Fall mit zwischen den Zeitpunkten und variierender Beleuchtungsstärke ergibt sich das folgende Integral:

Die Maßeinheit der Belichtung ist demzufolge die Luxsekunde (abgekürzt: lx s).

Wenn die Beleuchtungsstärke zeitlich konstant ist, also

- ,

dann vereinfacht sich die Berechnung der Belichtung wie folgt:

Die Anzahl der Photonen mit einer bestimmten Wellenlänge , die während der Belichtung auf die Fläche fallen, ergibt sich dann wie folgt:

Beim Tagsehen kann bei einer Wellenlänge von 555 Nanometern zum Beispiel gewählt werden, so dass sich ergibt:

Beim Nachtsehen liegt das Empfindlichkeitsmaximum des menschlichen Auges bei einer Wellenlänge von 507 Nanometern, so dass sich ergibt:

Belichtungswert

BearbeitenIm Zusammenhang mit der Photographie wird die Leuchtdichte oft in einen einheitenlosen Belichtungswert (nach DIN 19017) oder (englisch: exposure value) umgerechnet. Mit dem Belichtungswert als Exponent der Basis 2 kann die Leuchtdichte auf eine Referenzleuchtdichte bezogen werden:

Die Referenzleuchtdichte ergibt sich aus einer empirisch zu ermittelnden Konstante , die je nach Messverfahren beziehungsweise Vorzugswerten zwischen 10,6 und 16,9 (oft 12,5 oder 14,0, nach DIN 19017 13,3 bis 16,9) Candelasekunden pro Quadratmeter liegt:

Sie bezieht sich heute auf eine Belichtungszeit von einhundert Sekunden (früher eine Sekunde):

- mit

Somit beträgt die entsprechende Referenzleuchtdichte je nach Messverfahren:

Die Leuchtdichte kann auch mit der am Objektiv einer Kamera gegebenen beziehungsweise eingestellten Blendenzahl (siehe auch Abschnitt Blendenzahl) und der Belichtungszeit bestimmt werden:

steht hierbei für den maßeinheitenlosen Belichtungsindex (englisch: exposure index, E.I.), der typischerweise mit den ISO-Hauptwerten …, 50, 100, 200, 400, … oder auch Zwischenwerten angegeben wird und der auf eine verwendete Filmempfindlichkeit beziehungsweise eine äquivalente Bildsensorempfindlichkeit abgestimmt werden kann. Der Belichtungsindex ist umgekehrt proportional zur Belichtung und ist unabhängig von den Eigenschaften des verwendeten Films oder Bildsensors. Als Bezugswert für die Belichtung wird nach ISO 2721 ein Wert von 10 Luxsekunden angenommen:

Die Leuchtdichte kann daher auch wie folgt zeitunabhängig über die oben definierte Beleuchtungsstärke (trotz des ähnlichen Formelzeichens nicht zu verwechseln mit dem einheitenlosen Lichtwert des APEX-Systems oder dem einheitenlosen Belichtungswert ) berechnet werden:

Ferner können natürlich auch die erforderliche Belichtungszeit t oder die erforderliche Blendenzahl k ermittelt werden, wenn alle anderen Parameter bekannt sind:

Der Belichtungswert kann wie folgt aus der ermittelten Leuchtdichte oder bei maximal ausgenutzter Leuchtdichte aus den Aufnahmeparametern berechnet werden:

Und entsprechend:

- Extreme Belichtungswerte

-

Aufnahme der Sonnenscheibe mit einigen kleinen Sonnenflecken mit einem Neutraldichtefilter mit einem Promille Transmission bei einer Blendenzahl 8, einem Belichtungsindex von ISO 200 und einer Belichtungszeit von 1/32000 Sekunde (der Belichtungswert der Sonnenscheibe betrug 30 EV).

-

Aufnahme der Milchstraße mit einem Fischaugenobjektiv bei einer Blendenzahl 2,8, einem Belichtungsindex von ISO 6400 und einer Belichtungszeit von 40 Sekunden (der Belichtungswert der Himmelssphäre betrug unter -8 EV).

APEX-System

BearbeitenDie einheitenlosen Leitwerte des APEX-Systems sind wie folgt definiert (vergleiche hierzu auch die ehemalige Norm DIN 19017, die ISO 2720 sowie das APEX-System (Additive System of Photographic Exposure)):

Der Blendenleitwert (englisch: aperture value):

Der Zeitleitwert (englisch: time value) wird auf eine Sekunde bezogen:

Der Lichtwert (englisch: exposure value, nicht zu verwechseln mit Beleuchtungsstärke oder dem Belichtungswert ):

Der Empfindlichkeitsleitwert (englisch: sensitivity value):

Der Helligkeitsleitwert (englisch: brightness value, umgangssprachlich auch "Helligkeitswert"):

Und entsprechend:

Beziehungsweise:

Astronomie

BearbeitenWenn ein Stern den Lichtstrom erzeugt, wird dessen Licht in der Regel in den gesamten Raum emittiert. Die Lichtstärke des Sterns ergibt sich somit zu:

Wird der Stern mit einem Teleskop der Öffnungsweite beobachtet, dann tritt nur ein winziger Bruchteil der Strahlung in das Teleskop mit der Querschnittsfläche :

Der sehr kleine objektseitige Raumwinkel , den ein solches Teleskop vom Stern erfasst, der sich in der Entfernung befindet, ergibt sich zu:

Der Anteil des Lichtstroms , der vom als punktförmig angenommenen Stern in das Teleskop eintritt, ergibt sich dann folgendermaßen:

Der bildseitig erfasste Raumwinkel ergibt sich aus der Brennweite des Teleskops beziehungsweise der Blendenzahl , da ein Stern wegen seiner sehr großen Entfernung in die Brennebene abgebildet wird:

Somit ist die Lichtstärke im Brennpunkt des Teleskops: